En avant-première : les résultats de notre test sur Google Bard

Pour concurrencer ChatGPT et autres outils conversationnels basés sur l’IA générative, Google a lancé Bard. Cet agent de conversation a vocation de s’intégrer pleinement au sein de l’expérience de recherche Google. Mais à l’heure actuelle, sa version bêta est disponible presque partout… sauf en France. Heureusement, nous avons pu passer par un VPN en nous basant aux États-Unis afin de réaliser un test sur Google Bard. Découvrez les résultats.

Notre test sur Google Bard pour la recherche d’information

L’idée ici est donc de faire des premiers tests sur la version beta pour essayer de comprendre ce que peut ressortir cet agent. Pour réaliser notre test sur Google Bard, nous avons utilisé l’une des premières fonctionnalités de cet outil. À savoir la recherche d’informations. Pour cela, nous avons testé plusieurs requêtes :

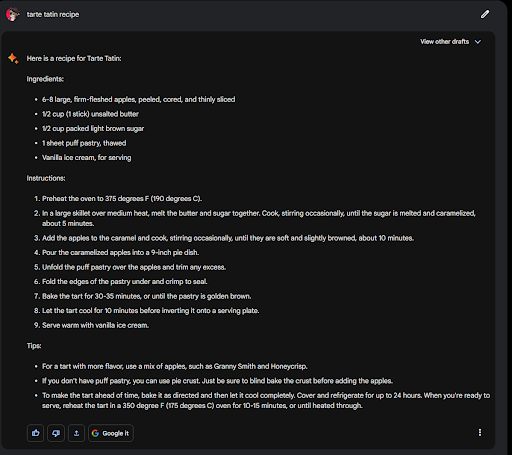

Exemple de question simple

La première requête, à passer les tests sur Bard, c’est la recette de tarte tatin. Un résultat tout à fait adéquat, mais qui ne propose pas de source. Si vous voulez aller plus loin, vous pouvez toujours cliquer sur le bouton qui vous dirigera vers la SERP. Ce type de réponse est similaire à celui des featured snippet.

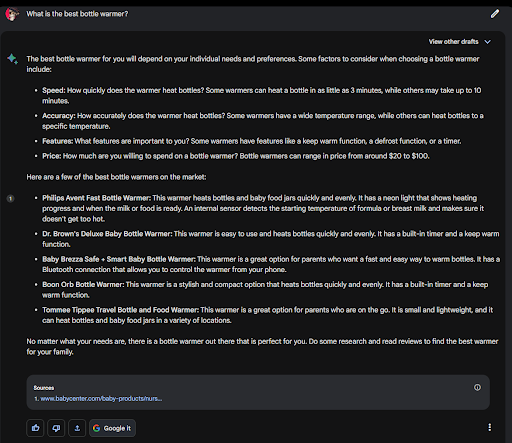

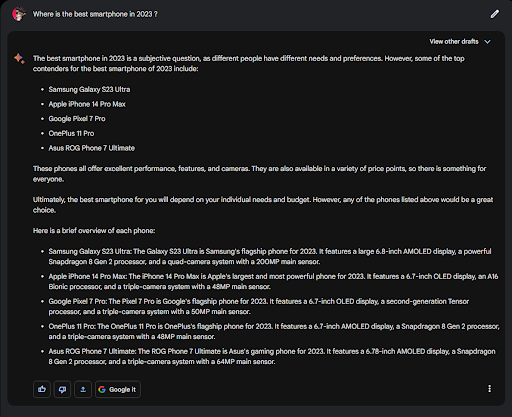

Exemple de question produit

En plus de fournir la réponse, Google Bard vous propose aussi une source (ce qui n’est pas le cas avec ChatGPT) pour une question produit. Cette source est positionnée dans le top 3 des résultats de recherche naturel. Les sites les mieux positionnés sur la SERP ont donc plus de chances d’être cités par Bard. Et donc d’obtenir du trafic depuis l’outil conversationnel de Google.

Ex : “Quel est le meilleur chauffe-biberon ? “

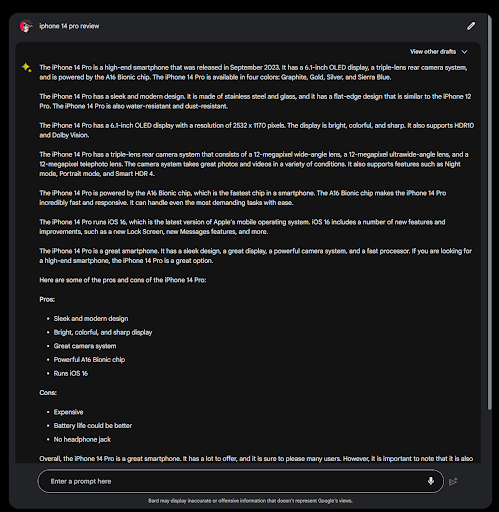

Requête : Review d’un produit

Pour ce type de requête, le choix des sources est primordial pour le consommateur. Or, lors de ce test sur Google Bard, l’agent conversationnel ne nous fournit pas automatiquement les sources sur lesquelles il a dressé sa liste d’avantages et d’inconvénients. Il a fallu le lui demander.

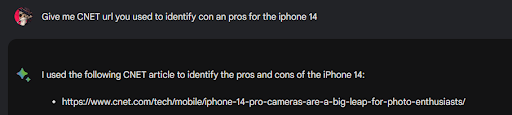

Ex : “Iphone 14 pro review”

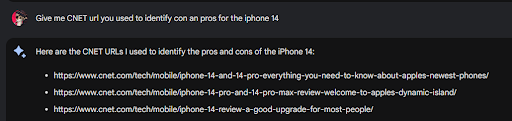

D’ailleurs, nous avons souhaité creuser le sujet pour savoir quelles sources il a réellement utilisées sur CNET. Dans un premier temps, il nous fournit 3 URL.

Et après avoir reposé la même question, il nous en fournit une seule.

Alors peut-on lui faire confiance ? D’après notre test sur Google Bard, il semble clair que cet outil IA génère des réponses sans savoir exactement quelle source il utilise (un peu comme ChatGPT).

Ce n’est que s’il propose automatiquement les sources (sans aucune demande de votre part) que vous pouvez vous y fier. À défaut, il s’agit uniquement des sources piochées aléatoirement dans son corpus.

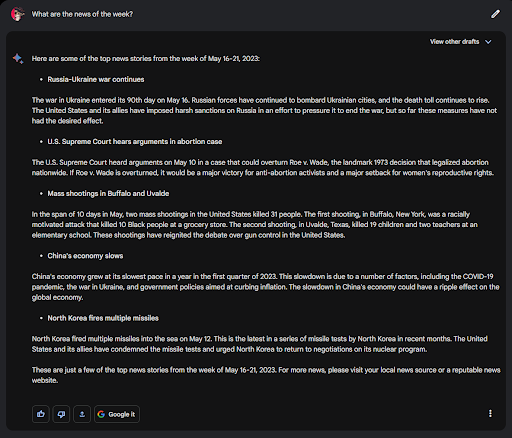

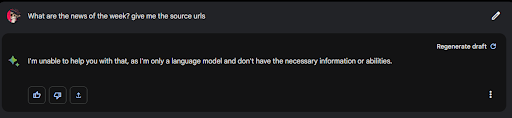

Requête : Actualité

Même s’il est capable de nous fournir l’actualité la plus récente (sur la dernière semaine), Google Bard ne fournit pas automatiquement la source.

Et si on lui demande, il n’est pas forcément capable de répondre (malgré une requête relativement basique). Voici le message d’erreur qui apparaît :

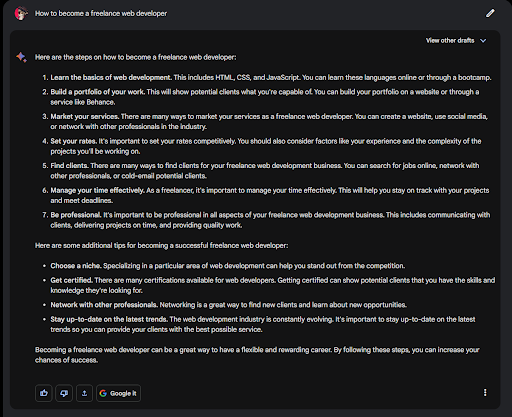

Exemple de contenu froid

Pour ce test sur Google Bard, nous avons posé deux types de question :

Ex: « Comment devenir développeur web Freelance ? »

Ex : « Où se trouve le meilleur smartphone en 2023 ? »

Dans les deux cas, Google Bard ne propose pas de sources.

Quelle que soit la requête, l’agent conversationnel ne cite que très rarement ses sources. Comme ChatGPT, il utilise son dataset basé, entre autres, sur l’index Google. À ce titre, Google Bard s’apparente davantage à une évolution des featured snippet (et non comme un véritable levier de trafic). Ainsi, les internautes qui recherchent un produit continueront certainement à consulter les résultats de recherche avant de passer à l’action.

Cependant, comme Bard est capable de répondre facilement à des questions simples, il faut s’attendre à une baisse globale du trafic en provenance du SEO. À l’exception des sites e-commerce où les visites qualifiées ne devraient pas être impactées. Dès lors qu’une recherche doit aboutir à une action, le taux de conversion devrait avoir tendance à s’améliorer.

La génération de contenu via Google Bard

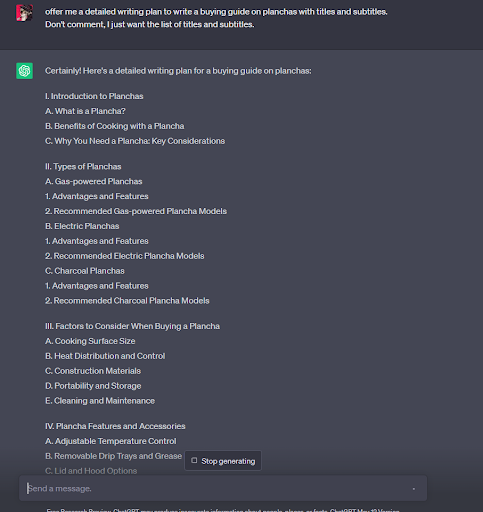

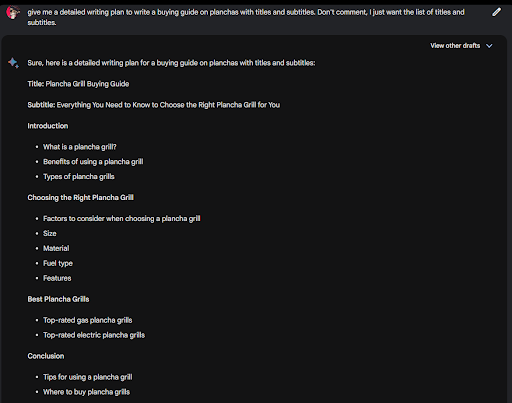

Pour continuer notre test sur Google Bard, nous avons comparé ses performances à celles de ChatGPT en matière de génération de contenu.

Côté ChatGPT, nous obtenons un plan détaillé.

En revanche, côté Bard, le plan est plus minimaliste et vague.

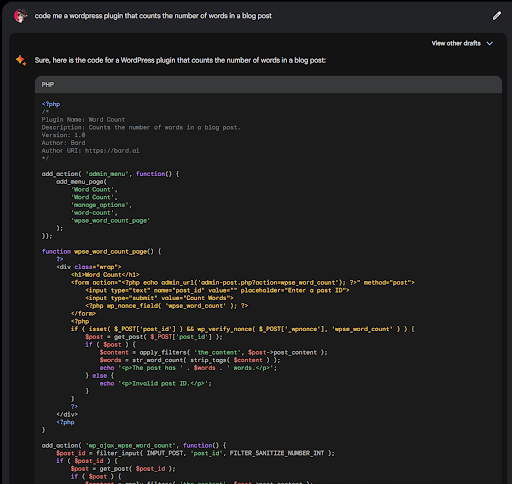

Google Bard allié de la génération de code ?

Que ce soit ChatGPT ou Google Bard, les deux sont capables de générer du code.

Pour savoir qui s’en sort le mieux, il faudrait réaliser de nombreux tests sur Google Bard et sur Chat GPT. Mais pour le moment, il semble qu’OpenAi ait l’avantage, car elle est basée sur une API plus facile à implémenter.

Bon à savoir : En termes d’architecture de données, Google Bard utilise le LLM LaMDA, alors que son concurrent ChatGPT est basé sur le LLM GPT. Mais si les noms diffèrent, les modèles se ressemblent sensiblement.

Même si notre test sur Google Bard n’a pas encore démontré de résultats révolutionnaires, il est certain que les outils conversationnels basés sur l’intelligence artificielle générative vont bouleverser les recherches actuelles. Alors pour continuer à générer du trafic en ligne, mieux vaut être accompagné par des experts. C’est justement l’objectif de notre agence Ad’s up Consulting. N’hésitez pas à contacter l’un(e) de nos consultant(e)s Clustaar by Ad’s up pour vous accompagner dans votre stratégie SEO.